- (Обновлено:

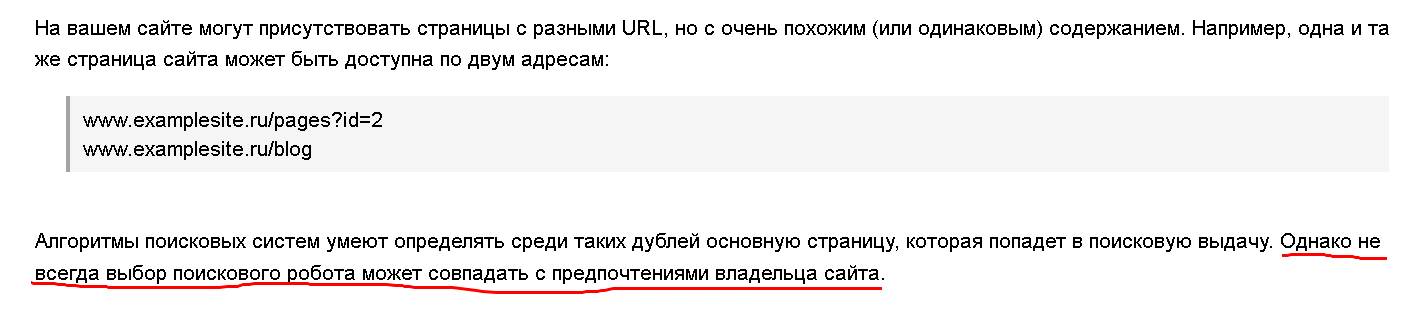

Поисковые алгоритмы постоянно развиваются, часто уже сами могут определить дубли страницы и не включать такие документы в основной поиск. Тем не менее, проводя экспертизы сайтов, мы постоянно сталкиваемся с тем, что в определении дублей алгоритмы еще далеки от совершенства. Вот что пишут о дублях представители Яндекса:

Я думаю, не стоит надеяться, что в вашем случае алгоритм оценит все страницы правильно и его выбор совпадет с вашим 😉 – лучше самому избавиться от дублей на сайте.

Я думаю, не стоит надеяться, что в вашем случае алгоритм оценит все страницы правильно и его выбор совпадет с вашим 😉 – лучше самому избавиться от дублей на сайте.

Почему нужно избавляться от дублей?

Предлагаю для начала рассмотреть, чем опасны дубли страниц.

Ухудшается индексация сайта

Если в вашем проекте несколько тысяч страниц, и на каждую из них создается по одному дублю, то объем сайта уже «раздувается» в два раза. А что, если создается не один дубль, а несколько? В прошлом году мы проводили экспертизу новостного портала, в котором каждая новость автоматически публиковалась в семи разделах, то есть каждая страница сразу создавалась еще с шестью дублями.

Неправильно распределяется внутренний ссылочный вес

Часто дубли на сайте появляются в результате неправильных внутренних ссылок. В итоге страницы-дубли могут считаться более значимыми, чем основная версия. Не стоит забывать и про пользовательские факторы. Если посетитель попал на дубль страницы, то, соответственно, измеряются ее показатели, а не оригинала.

Изменение релевантной страницы в поисковой выдаче

Поисковый алгоритм в любой момент может посчитать дубль более релевантным запросу. Смена страницы в поисковой выдаче часто сопровождается существенным понижением позиций.

Потеря внешнего ссылочного веса

Пользователя заинтересовал ваш товар или статья, и он решил поделиться информацией и поставить на страницу ссылку. Если он был на странице-дубле, то сошлется именно на нее. В итоге вы потеряете полезную естественную ссылку.

Как найти дубли?

Теперь давайте рассмотрим, как можно найти внутренние дубли на сайте.

1. Анализ данных Google Webmasters

Пожалуй, самый простой из способов. Для того чтобы найти страницы дублей, вам будет достаточно зайти в панель инструментов, выбрать вкладку «Вид в поиске» и перейти по ссылке «Оптимизация html»:

Наша цель – это пункты:

— «Повторяющееся метаописание». Здесь отображены страницы с одинаковыми описаниями (description);

— «Повторяющиеся заголовки (теги title)». В этом пункте находится список страниц с одинаковыми заголовками (Title).

Дело в том, что на страницах обычно совпадает не только контент, но и мета-данные. Проанализировав список страниц, отображаемых в этих вкладках, легко можно выявить такие дубли. Мы рекомендуем периодически проверять вышеупомянутые вкладки панели инструментов на наличие новых ошибок.

Проверить страницы на совпадающие заголовки можно даже в том случае, если доступа к панели у вас нет. Для этого вам нужно будет воспользоваться расширенным поиском поисковой системы или сразу ввести в поисковую строку соответствующий запрос.

Для Яндекса:

site: siteclinic.ru title:(анализ сайтов)

Для Google:

site: siteclinic.ru intitle:анализ сайтов

Разумеется, необходимо подставить свой домен и часть заголовка, дубль которого вы ищете.

2. Анализ проиндексированных документов

Анализ в первую очередь лучше проводить в той поисковой системе, в индексе которой находится больше всего страниц. В большинстве случаев это Google. С помощью оператора языка запросов «site» легко получить весь список проиндексированных страниц. Вводим в строку поиска:

site:siteclinic.ru (не забудьте указать имя своего домена) и получаем список проиндексированных страниц.

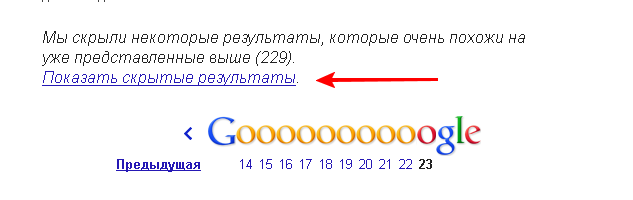

В конце списка вы увидите ссылку «Показать скрытые результаты». Нажмите на нее, чтобы увидеть более полный список страниц:

Просматривая выдачу, обращайте внимание на нестандартные заголовки и url страниц.

Например, вы можете увидеть, что в выдаче попадаются страницы с идентификаторами на конце, в то время как на сайте настроены ЧПУ. Нередко уже беглый анализ проиндексированных страниц позволяет выявить дубли или другие ошибки.

Если на сайте большой объем страниц, то при анализе может помочь программа Xenu. Об использовании этого инструмента можно прочесть на блоге Сергея Кокшарова.

3. Поиск дублей по части текста

Два предыдущих способа помогают выявить дубли в тех случаях, когда на страницах совпадают мета-данные. Но могут быть и другие ситуации. Например, статья на сайте попадает сразу в несколько категорий, при этом в title и description автоматически добавляется название категории, что делает мета-данные формально уникальными. В этом случае ошибки в панели инструментов мы не увидим, а при ручном анализе сниппетов страниц такие дубли легко пропустить.

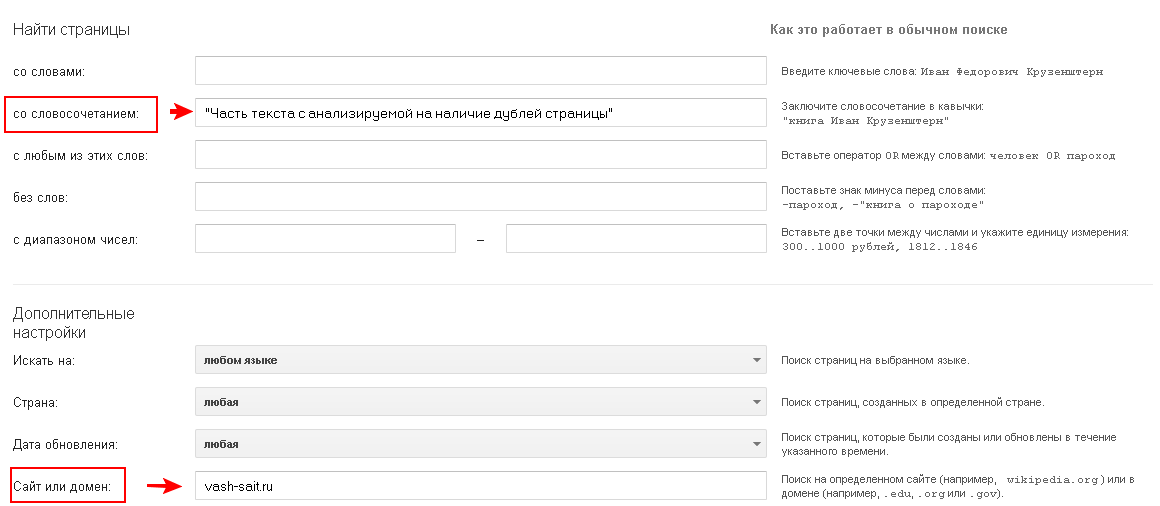

Для того чтобы выявить на сайте подобные страницы, лучше всего подойдет поиск по части текста.

Для этого нужно воспользоваться инструментом «расширенный поиск» и произвести поиск на сайте по части текста страницы. Текст вводим в кавычках, чтобы искать страницы с таким же порядком слов и формой, как в нашем запросе.

Так выглядит расширенный поиск в Яндексе:

На сайтах может быть много сотен или даже тысяч страниц. Разумеется, не нужно анализировать все страницы. Их можно разбить по группам. Например, главная, категории, товарные карточки, новости, статьи. Достаточно будет проанализировать по 2-3 страницы каждого вида, чтобы выявить дубли или убедиться, что на сайте все в порядке.

Чистим сайт от дублей

После того как дубли обнаружены, можно приступать к их удалению.

Находим и устраняем причину появления дублей

Первое, что необходимо сделать – найти причину, из-за которой дубли на сайте появляются, и постараться ее устранить.

Причины могут быть различные, например:

- ошибки в логике структуры сайта;

- технические ошибки;

- различные фильтры и поиск по сайту.

В каждом случае ситуацию необходимо рассматривать индивидуально, но если дубли функционально не полезны, то от них лучше просто отказаться.

Указываем канонический адрес страницы

Если страницы-дубли по каким-то причинам нельзя удалить, то следует указать поисковым роботам, какая страница является основной (канонической). Google ввел для этого специальный атрибут rel=»canonical» (рекомендации по использованию атрибута).

Через некоторое время его стал поддерживать и Яндекс . И на сегодняшний день это основное официальное средство для борьбы с дублями страниц.

Использование 301 редиректа

До внедрения rel=»canonical» 301 редирект был основным способом склейки страниц-дублей. И сейчас разработчики и оптимизаторы продолжают активно использовать 301 редирект для переадресации на основное зеркало сайта или со страниц с «/» или без него на конце.

Запрет к индексации в robots.txt

В файле robots.txt мы можем запретить доступ к определенным разделам или типам страниц, например, страницам, формируемым в результате поиска по сайту. Но это не избавит нас от дублей страниц в Google. Дело в том, что доступ к страницам будет запрещен, но если страницы уже попали в индекс, они после добавления запрета исключены не будут.

Приведу цитату из рекомендаций Google:

Следует отметить, что даже если вы запретите поисковым роботам сканировать содержание вашего сайта с помощью файла robots.txt, возможно, что Google обнаружит его другими способами и добавит в индекс. Например, на ваш контент могут ссылаться другие сайты.

Для того чтобы страница была удалена из индекса, на нее необходимо добавить <meta name=»robots» content=»noindex»>, но при этом важно, чтобы страница не была закрыта в robots.txt. Иначе поисковый робот на нее не зайдет.

Еще одна цитата:

Если ваша страница продолжает появляться в результатах, вероятно, мы еще не просканировали ваш сайт после добавления тега. (Кроме того, если вы заблокировали эту страницу с помощью файла robots.txt, мы также не сможем увидеть этот тег.)

В связи с этим, если дубли на сайте уже есть, robots.txt не поможет удалить их из индекса Google.

Остается пожелать оптимизаторам успехов в борьбе с дублями и развитии своих проектов.

Еще по теме:

- Как создать убийственный контент: построение карты ключевых слов

- Что делать с рекламой на сайте, или Чиним двигатель торговли

- Как и зачем оптимизировать страницу контактов?

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

-

Ксенья Юрьевна

-

Vanchik

-

Василий

-

Ксенья Юрьевна

-

Александр

-

Sayxan

-

Сергей Ждан

(6 оценок, среднее: 4,83 из 5)

(6 оценок, среднее: 4,83 из 5)