- (Обновлено:

Поисковые системы постоянно обновляют свои алгоритмы и борются за «чистоту» выдачи. В связи с этим ситуация, когда мы видим в своих аккаунтах GoogleAnalytics (далее GA) просадку трафика по органическому поиску, – не редкость. В таких случаях возникает резонный вопрос: почему? Сегодня я хочу рассказать, как выявить возможные причины снижения трафика из поисковой системы Google.

Откуда просел трафик

Итак, первое, что нам необходимо сделать, – это убедиться в том, что количество посетителей уменьшилось именно из органического поиска Google. Потому что если трафик резко просел со всех поисковых систем, это может быть связано с техническими проблемами или с сезонным спадом.

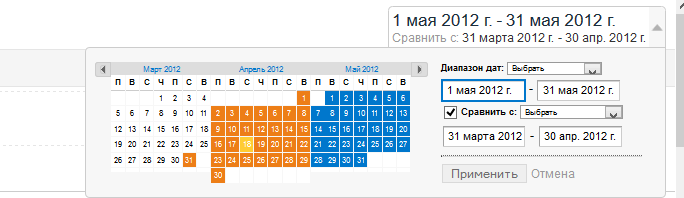

Для этого в GA необходимо выбрать сравнение периодов до и после просадки трафика:

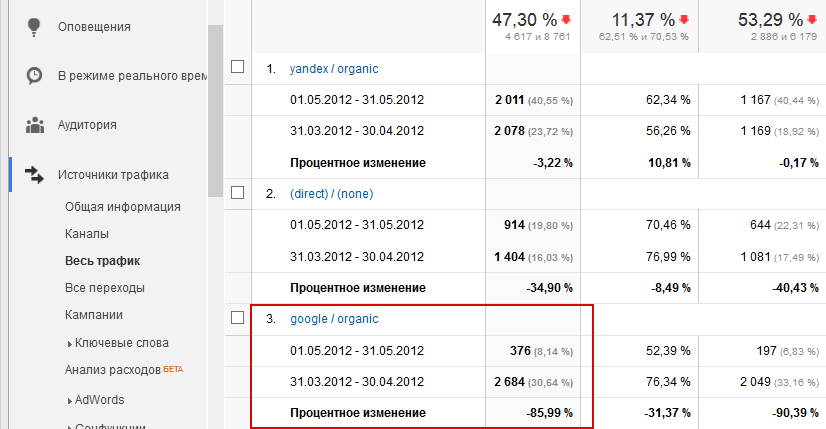

и проделать следующий путь в GA «Источник трафика» — > «Весь трафик»:

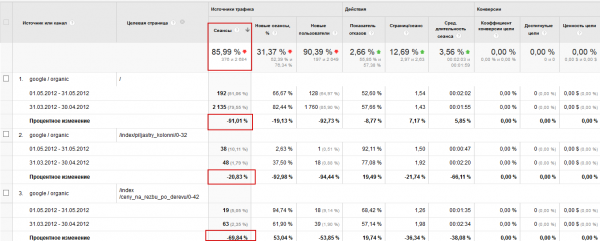

Как видно, трафик из «google / organic» просел на 86%, тогда как в «yandex / organic» лишь на 3% — это говорит о том, что проблемы именно с Google.

Причина №1 – Технические проблемы

Несмотря на то, что в большинстве случаев технические ошибки приводят к просадке трафика из всех органических источников, бывают ситуации, когда на некоторые из них реагирует только Google. Рассмотрим основные технические ошибки, за которые сайт может быть пессимизирован.

- Сайт закрыт от индексации в robots.txt

Вот как это может выглядеть:

User-Agent: Googlebot

Disallow: /

Или

User-Agent: *

Disallow: /category/

В первом случае сайт полностью закрыт от индексации только для робота Google, во втором случае закрыт раздел /category/ для индексации всем поисковым роботам.

Такое иногда случается по ошибке и невнимательности. Всегда проверяйте robots.txt.

- Технические дубли

Некоторые cms могут генерировать различные дубли, особенно это часто происходит при использовании фильтров или поиска на сайте.

Также очень часто главная страница доступна по нескольким адресам. Например, www.site.ru и site.ru или www.site.ru и www.site.ru/index.php. В данном случае необходимо настроить 301 редирект.

Более подробно о технических дублях написано на нашем блоге в этой статье.

- Не настроен или слетел 301 редирект

Редко, но встречаются проблемы с 301-м редиректом. Например, после смены структуры URL забывают настроить 301 редирект, что приводит к просадке позиций и трафика.

Также бывает, что после смены домена и правильной настройки 301 редиректа он со временем слетает. Необходимо следить за корректностью 301 редиректа (ответ сервера можно проверить с помощью плагина для Firefox).

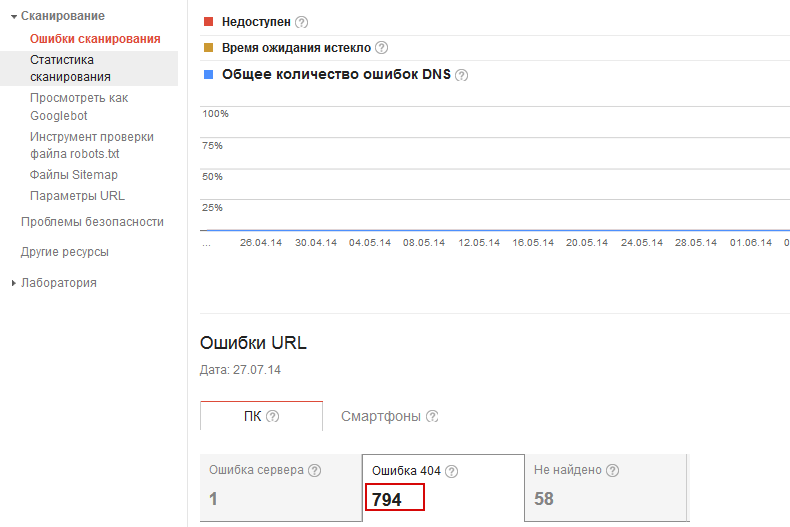

- Большое количество битых ссылок

Большое количество ссылок, которые ведут на страницы с 404 ошибкой, могут негативно сказаться на рейтинге сайта, от таких ссылок нужно избавляться. Посмотреть количество и узнать местоположение битых ссылок вы можете через GoogleWebmastersTools (далее GWT):

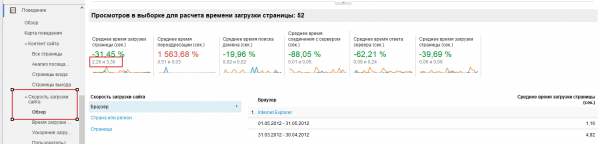

- Сайт недоступен или низкая скорость загрузки

Google очень негативно реагирует на медленную скорость загрузки страниц (более 5 секунд). Узнать скорость загрузки можно через GA:

Проблемы могут быть как с хостингом, так и с сайтом, каждый случай нужно рассматривать индивидуально.

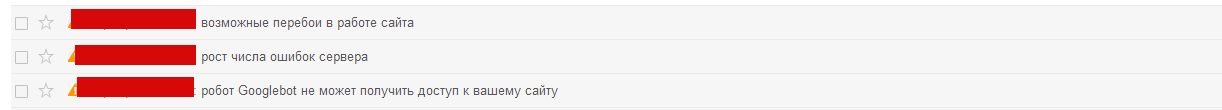

Кроме того, сайт мог быть недоступен в момент, когда на него заходил GoogleBot, в таком случае вы можете получить, разные сообщения в GWT:

Если ошибки связаны с сервером, то стоит задуматься о смене хостера.

Причина №2 — ошибки внутренней оптимизации

В большинстве случаев, если на сайте есть ошибки внутренней оптимизации, снижение трафика связано с наложением фильтра Panda. Это основной фильтр Google, который нацелен на борьбу с низкокачественной внутренней оптимизацией.

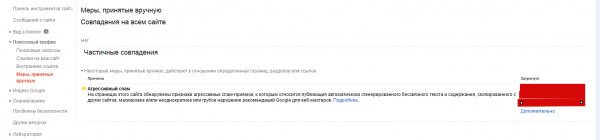

Также в последнее время стали приходить сообщения о наложении ручных санкций за агрессивный спам с примерами спамных страниц:

Если вы получили такое сообщение, то будет достаточно избавиться от спама на затронутых страницах.

Определить фильтр Google Panda сегодня достаточно сложно. Раньше данный фильтр запускался в определенные даты, и если падение трафика совпадало с запуском, это значило, что на сайт заходила Panda. Сегодня данный алгоритм интегрирован в основной индекс и запускается каждый месяц в течение 10-дневного периода, но никто не знает, когда он начинается и когда заканчивается.

В связи с этим мы рекомендуем проанализировать страницы, у которых просел трафик, на ошибки внутренней оптимизации, а также сравнить их с теми, у которых посещение не изменилось либо выросло.

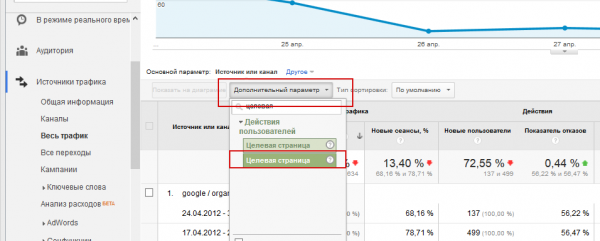

Чтобы увидеть страницы, у которых упала посещаемость, в отчете «Весь трафик» необходимо зайти на «google / organic» и добавить «Дополнительный параметр» — «Целевая страница»:

Таким образом мы получим отчет следующего вида:

Сайт может быть пессимизирован за следующие ошибки внутренней оптимизации:

- Неуникальный контент – сегодня Google уделяет данному фактору очень большое значение. Текст на вашем сайте должен быть уникальным (проверить можно с помощью сервиса etxt), а если он не уникальный, то сайт должен являться первоисточником (вставляем фрагмент текста в поисковую строку – сайт должен быть на первом месте). Если сайт не является первоисточником, есть два пути выхода из ситуации: 1. Подать жалобу в Google на нарушение авторских прав через специальный сервис. 2. Переписать текст.

- Смысловые дубли – после последнего обновления Panda 4 было замечено, что Google понижает не только за прямые дубли, но и за смысловые тоже. Если у вас на сайте есть близкие по смыслу тексты, рекомендуем использовать атрибут rel=canonical с указанием на основную страницу (подробнее в справке Google).

- Страницы в дополнительных результатах – если алгоритм считает страницы неполезными, то он добавляет их в так называемые supplemental results, которые не видны в основном индексе. Обычно в дополнительные результаты отправляются страницы с дублированным контентом. Проверить, сколько страниц находится в основном индексе, можно введя в поисковую строку Google следующую конструкцию: site:name.ru/&, общий индекс — site:name.ru. Вычитая из общего индекса основной, получим количество страниц в supplemental results.

- Дубли title и description – это классическая ошибка, которой следует избегать, т.к. для Google правильно заполненные title и description являются одними из приоритетных факторов ранжирования.

- Большое количество рекламы – рекламы не должно быть больше, чем основного контента, кроме того, блоки рекламы не должны мешать восприятию основной информации. За большое количество рекламы Google может понизить рейтинг сайта.

- Неудобная структура – плохое юзабилити, запутанная навигация, неинформативный первый экран также являются факторами, за которые может быть наложен фильтр Panda. Найти дубли title и метатегов можно в GMT:

- Списки ключевых слов – перенасыщение текстов, title и метатегов ключевыми словами – прямой путь к фильтру. Кроме того, частое выделение тегом strong также может сыграть в сторону наложения санкций.

Если во время анализа сайта вы нашли данные ошибки, то, скорее всего, на сайт наложен фильтр Panda. Исправьте ошибки, и через время Google должен вернуть трафик (Кейс: Как мы справились с Пандой и вернули трафик на сайт).

Причина № 3 — ошибки внешней оптимизации

Сегодня Google ведет агрессивную борьбу с неестественной ссылочной массой. Потеря трафика из-за санкций за ссылочный профиль очень распространена. Есть два вида санкций: автоматические (фильтр называется Penguin) и ручные.

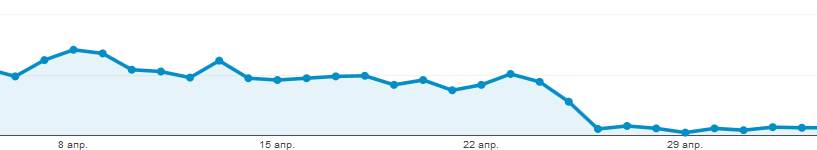

Автоматические санкции накладываются во время обновления алгоритма Penguin. Если дата обновления совпадает с падением трафика, то с большой долей вероятности можно говорить о том, что на сайт наложен фильтр. Посмотреть даты всех апдейтов можно на сайте.

Пример наложения GooglePenguin в апреле 2012 года:

Если на сайт наложены ручные санкции, то в GMT вы увидите следующее сообщение:

Причины наложения санкций и в том, и в другом случае одинаковые:

- Покупные ссылки

- В анкор-листе преобладает анкор с ключевым словом

- Скачки ссылочной массы (как увеличение, так и снижение)

- Сквозные ссылки из шаблонной части сайта (особенно футер)

- Низкокачественные доноры, заспамленные ссылками и с низкой посещаемостью

- Нетематические доноры

Для снятия ручных санкций достаточно почистить ссылочный профиль и отправить сайт на пересмотр. Если ссылки не нарушают рекомендации Google, санкции будут сняты. Автоматический фильтр может быть снят только после очередного обновления алогритма. Подробнее о ссылочных санкциях Google вы можете прочитать на нашем блоге.

Просадка также может быть связана с изменением алгоритмов или с увеличением конкурентности, поэтому следите за информацией в интернете и за выдачей в ТОП.

Вывод

Итак, мы рассмотрели возможные причины просадки трафика. Подводя итог, нужно сказать, что если у вас на сайте просел трафик, прежде всего нужно проверить его на ручные санкции и Пингвин, т.е. очевидные возможные причины. Если ни ручных санкций, ни Пингвина на сайте нет, можно переходить к анализу технических ошибок и далее к рассмотрению внутренней оптимизации сайта.

Всегда анализируйте сайт в комплексе, возможно, причин несколько, только полный анализ сможет привести вас к успеху.

Еще по теме:

- Есть ли связь Пингвина с Минусинском?

- Конверсия сайта: как считать, от чего зависит

- Асессорская инструкция Google: критерии оценки качества страниц (Часть 1)

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

-

v1st

-

Bakalov

-

Дмитрий

-

Yurbol

-

Никита

(6 оценок, среднее: 4,50 из 5)

(6 оценок, среднее: 4,50 из 5)