- (Обновлено:

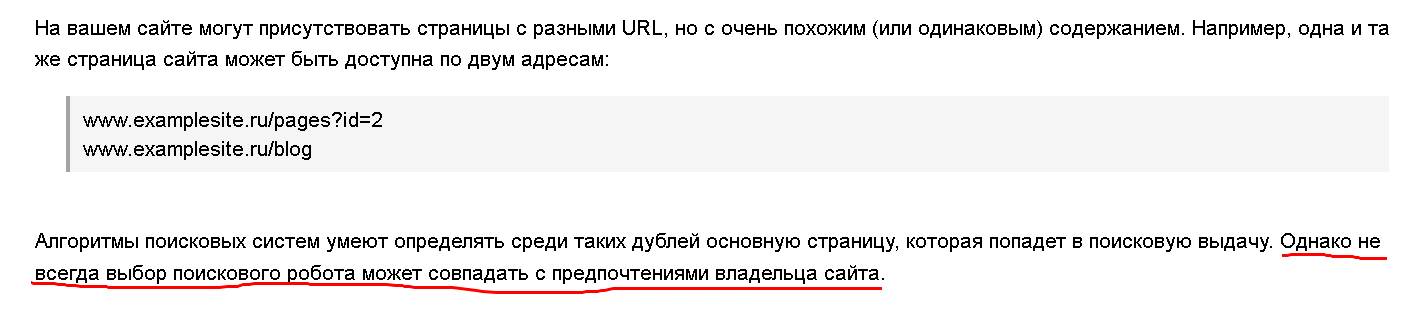

Пошукові алгоритми постійно розвиваються, часто вже самі можуть визначити дублі сторінки і не включати такі документи в основний пошук. Проте, проводячи експертизу сайтів, ми постійно стикаємося з тим, що у визначенні дублів алгоритми ще далекі від досконалості. Ось що пишуть про дублі представники Яндексу:

Я думаю, не варто сподіватися, що у вашому випадку алгоритм оцінить усі сторінки правильно і його вибір співпаде з вашим 😉 – краще самому позбутися від дублів на сайті.

Я думаю, не варто сподіватися, що у вашому випадку алгоритм оцінить усі сторінки правильно і його вибір співпаде з вашим 😉 – краще самому позбутися від дублів на сайті.

Чому потрібно позбавлятися від дублів?

Пропоную для початку розглянути, чим небезпечні дублі сторінок.

Погіршується індексація сайту

Якщо у вашому проекті кілька тисяч сторінок, і на кожну з них створюється по одному дублю, то обсяг сайту вже «роздувається» вдвічі. А що, якщо створюється не один дубль, а кілька? Минулого року ми проводили експертизу новинного порталу, в якому кожна новина автоматично публікувалася в семи розділах, тобто кожна сторінка відразу створювалася ще з шістьма дублями.

Неправильно розподіляється внутрішня контрольна вага

Часто дублі на сайті з’являються в результаті неправильних внутрішніх посилань. У результаті сторінки-дублі можуть вважатися більш значущими, ніж основна версія. Не варто забувати і про призначені для користувача фактори. Якщо відвідувач потрапив на дубль сторінки, то, відповідно, вимірюються її показники, а не оригіналу.

Зміна релевантної сторінки в пошуковій видачі

Пошуковий алгоритм у будь-який момент може почати вважати дубль більш релевантним запитом. Зміна сторінки в пошуковій видачі часто супроводжується істотним зниженням позицій.

Втрата зовнішньої посилальної ваги

Користувача зацікавив ваш товар або стаття, і він вирішив поділитися інформацією та поставити на сторінку посилання. Якщо він був на сторінці-дублі, то посилатиметься саме на неї. У підсумку ви втратите корисне природне посилання.

Як знайти дублі?

Тепер давайте розглянемо, як можна знайти внутрішні дублі на сайті.

1. Аналіз даних Google Webmasters

Мабуть, найпростіший із способів. Для того щоб знайти сторінки дублів, вам буде досить зайти в панель інструментів, вибрати вкладку «Вид у пошуку» і перейти за посиланням «Оптимізація html»:

Наша мета – це пункти:

– «Метаопис, що повторюється». Тут відображено сторінки з однаковими описами (description);

– «Заголовки (теги title), що повторюються». У цьому пункті знаходиться список сторінок з однаковими заголовками (Title).

Справа в тому, що на сторінках зазвичай співпадає не лише контент, але і мета-дані. Проаналізувавши список сторінок, що відображаються у цих вкладках, легко можна виявити такі дублі. Ми рекомендуємо періодично перевіряти вищезазначені вкладки панелі інструментів на наявність нових помилок.

Перевірити сторінки на заголовки, що співпадають, можна навіть у тому випадку, якщо доступу до панелі у вас немає. Для цього вам потрібно буде скористатися розширеним пошуком пошукової системи або відразу ввести у пошуковий рядок відповідний запит.

Для Яндексу:

site: siteclinic.ru title: (аналіз сайтів)

Для Google:

site: siteclinic.ru intitle: аналіз сайтів

Зрозуміло, необхідно підставити свій домен і частину заголовку, дубль якого ви шукаєте.

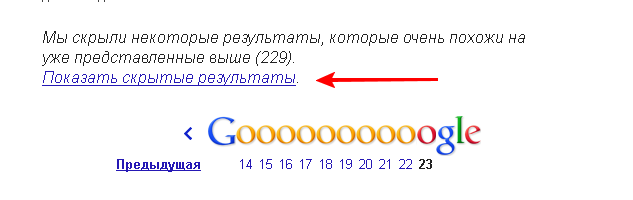

2. Аналіз проіндексованих документів

Аналіз ву першу чергу краще проводити в тій пошуковій системі, в індексі якої знаходиться найбільше сторінок. У більшості випадків це Google. За допомогою оператора мови запитів «site» легко отримати весь список проіндексованих сторінок. Вводимо в рядок пошуку:

site: siteclinic.ru (не забудьте вказати назву свого домену) і отримуємо список проіндексованих сторінок.

У кінці списку ви побачите посилання «Показати приховані результати». Натисніть на нього, щоб побачити більш повний список сторінок:

Переглядаючи видачу, звертайте увагу на нестандартні заголовки і url сторінок.

Наприклад, ви можете побачити, що у видачі трапляються сторінки з ідентифікаторами на кінці, у той час як на сайті налаштовані ЧПУ. Нерідко вже побіжний аналіз проіндексованих сторінок дозволяє виявити дублі або інші помилки.

Якщо на сайті великий обсяг сторінок, то під час аналізу може допомогти програма Xenu. Про використання цього інструменту можна прочитати на блозі Сергія Кокшарова.

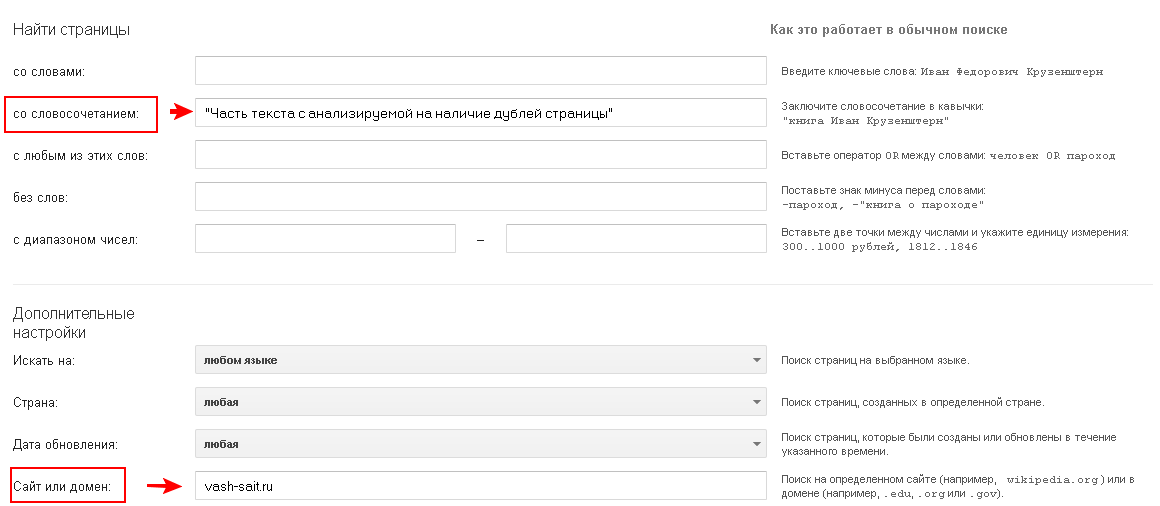

3. Пошук дублів за частиною тексту

Два попередні способи допомагають виявити дублі у тих випадках, коли на сторінках збігаються мета-дані. Але можуть бути й інші ситуації. Наприклад, стаття на сайті потрапляє відразу в кілька категорій, при цьому в title і description автоматично додається назва категорії, що робить мета-дані формально унікальними. У цьому випадку помилки в панелі інструментів ми не побачимо, а під час ручного аналізу фрагментів сторінок такі дублі легко пропустити.

Для того щоб виявити на сайті подібні сторінки, найкраще підійде пошук за частиною тексту.

Для цього потрібно скористатися інструментом «розширений пошук» та зробити пошук на сайті за частиною тексту сторінки. Текст вводимо в лапках, щоб шукати сторінки з таким самим порядком слів і формою, як у нашому запиті.

Так виглядає розширений пошук в Яндекс:

На сайтах можна знайти багато сотень або навіть тисяч сторінок. Зрозуміло, не потрібно аналізувати всі сторінки. Їх можна розбити на групи. Наприклад, головна, категорії, товарні картки, новини, статті. Досить буде проаналізувати 2-3 сторінки кожного виду, щоб виявити дублі або переконатися, що на сайті все гаразд.

Чистимо сайт від дублів

Після того як дублі виявлені, можна приступати до їх видалення.

Знаходимо й усуваємо причину появи дублів

Перше, що необхідно зробити, – знайти причину, через яку дублі на сайті з’являються, і постаратися її усунути.

Причини можуть бути різні, наприклад:

- помилки в логіці структури сайту;

- технічні помилки;

- різні фільтри та пошук на сайті.

У кожному випадку ситуацію слід розглядати індивідуально, але якщо дублі функціонально не корисні, то від них краще просто відмовитися.

Вказуємо канонічну адресу сторінки

Якщо сторінки-дублі з якихось причин не можна видалити, то слід вказати пошуковим роботам, яка сторінка є основною (канонічною). Google ввів для цього спеціальний атрибут rel=”canonical” (рекомендації щодо використання атрибуту).

Через деякий час його став підтримувати і Яндекс. І на сьогоднішній день це основний офіційний засіб для боротьби з дублями сторінок.

Використання 301 редиректу

До впровадження rel = “canonical» 301 редирект був основним способом склеювання сторінок-дублів. І наразі розробники та оптимізатори продовжують активно використовувати 301 редирект для переадресації на основне дзеркало сайту або зі сторінок зі «/» або без нього на кінці.

Заборона до індексації в robots.txt

У файлі robots.txt ми можемо заборонити доступ до певних розділів або типів сторінок, наприклад, сторінок, які формуються в результаті пошуку на сайті. Але це не позбавить нас від дублів сторінок у Google. Справа в тому, що доступ до сторінок буде заборонений, але якщо сторінки вже потрапили в індекс, вони після додавання заборони виключені не будуть.

Наведу цитату з рекомендацій Google:

Слід зазначити, що навіть якщо ви забороните пошуковим роботам сканувати вміст вашого сайту за допомогою файлу robots.txt, можливо, що Google виявить його іншими способами та додасть в індекс. Наприклад, на ваш контент можуть посилатися інші сайти.

Для того щоб сторінка була видалена з індексу, на неї необхідно додати <meta name = “robots” content = “noindex»>, але при цьому важливо, щоб сторінка не була закрита в robots.txt. Інакше пошуковий робот на неї не зайде.

Ще одна цитата:

Якщо ваша сторінка продовжує з’являтися в результатах, ймовірно, ми ще не просканували ваш сайт після додавання тегу. (Крім того, якщо ви заблокували цю сторінку за допомогою файлу robots.txt, ми також не зможемо побачити цей тег.)

У зв’язку з цим, якщо дублі на сайті вже є, robots.txt не допоможе видалити їх з індексу Google.

Залишається побажати оптимізаторів успіхів у боротьбі з дублями та розвитку своїх проектів.

Еще по теме:

- Безкоштовні джерела посилань і принципи безанкорного просування

- Атрибути Alt і Title для картинок. Відповіді на популярні питання

- Чек-ліст внутрішньої оптимізації сайту: 18 контрольних пунктів, обов’язкових до виконання

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

(6 оценок, среднее: 4,83 из 5)

(6 оценок, среднее: 4,83 из 5)