- (Обновлено:

- 8 минут

- Screaming Frog SEO Spider 9.2

- ComparseR 1.0.129

- Netpeak Spider 3.0

- Xenu’s Link Sleuth

- WildShark SEO Spider

- Majento SiteAnalayzer

- Висновки

Сьогодні уявити технічний аналіз сайту без парсеру неможливо. Ця програма допомагає виявити більшість технічних помилок, знайти биті посилання, несправні редіректи, дізнатися, чи правильно налаштований robots.txt, рівень вкладеності і багато іншого.

Парсерів багато. Вони різняться за своїм функціоналом, зручністю і, звичайно ж, ціною. Розглянемо кілька яскравих представників серед цих програм і оцінимо їх функціонал, зручність і час роботи.

Для оцінки функціоналу візьмемо перелік функцій, які обов’язково повинен мати «ідеальний» парсер:

- Пошук битих посилань.

- Вказівка вхідних і вихідних посилань сторінки.

- Вказівка типу і ланцюжки редиректів.

- Можливість фільтрувати сторінки:

- – використовувати регулярні вирази;

- – сканувати за правилами robots.txt, meta robots, canonical і т. д.

- Парсинг окремих URL.

- Виявлення дублів Title, Description і заголовків H.

- Вказівка рівня вкладеності.

- Вказівка заголовків H та їх кількості.

- Код відповіді сервера.

- Можливість зміни User Agent.

- Title та його довжина.

- Description і його довжина.

- Keywords і його довжина.

- Canonical.

- Meta robots.

- Alt і його довжина.

- Тип контенту.

Отже, у нас є 17 основних вимог. Окремо будемо рахувати додатковий функціонал, зручність і швидкість роботи.

Зручність, звичайно, показник суб’єктивний. За 5-бальною шкалою буду оцінювати, наскільки мені було зручно і просто працювати з програмою.

Швидкість роботи буде показана на прикладі сайту, розмір якого – близько 6 тис. сторінок, а до індексації дозволено близько 1500 (варто зазначити, що у сайту відкриті до індексації скрипти, тому він може парсити і їх). Для кожного інструменту будуть однакові умови парсинга.

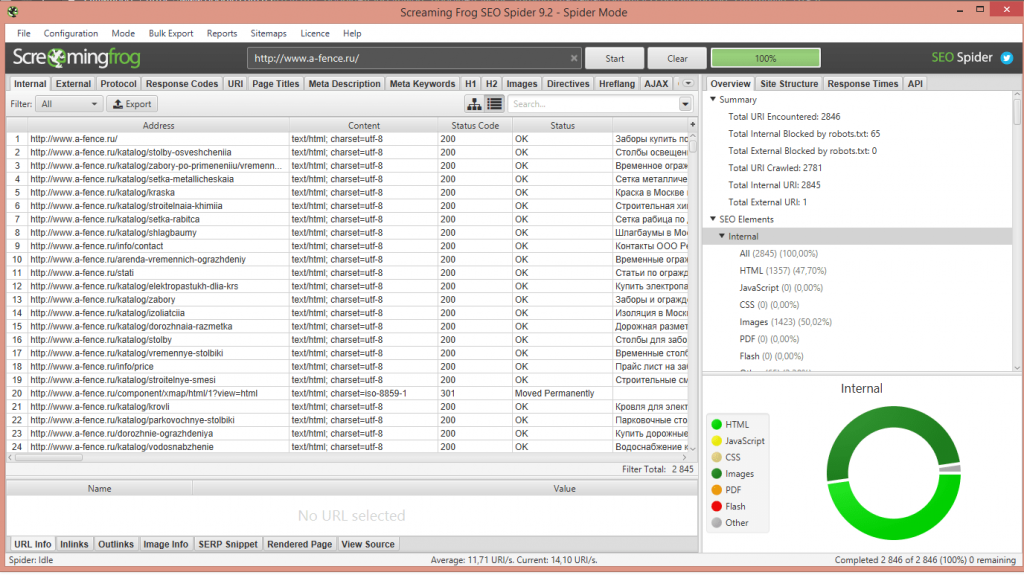

Screaming Frog SEO Spider 9.2

Screaming Frog – британський, всім відомий парсер. Це одна з кращих програм у своєму роді, але у неї «кусається» ціна і не самий зручний інтерфейс. За допомогою цього парсера можна зібрати безліч показників.

Його функціонал повністю відповідає списку обов’язкових можливостей. Єдиний мінус – не дуже зручний інтерфейс. Варто зазначити, що у Screaming Frog є великий мануал по роботі з ним, там можна знайти всю потрібну інформацію.

Окремо потрібно сказати про його зручність: не важко поверхнево подивитися дані, але для більш глибокого вивчення деколи доводиться дивитися мануал.

Додаткового функціоналу в інструменту досить. Ось найцікавіші можливості, на мою думку:

- Перевірка, як те чи інше заповнення robots.txt вплине на індексацію сайту.

- Перегляд структури сайту.

- Сканування сайтів, які вимагають авторизації.

- Генерація Sitemap.

- Пошук за кодом.

- Налаштування швидкості парсингу сайту.

З парсингом сайту впорався всього за 3 хвилини – це досить швидко, що є лише плюсом.

Оцінка: 17 балів

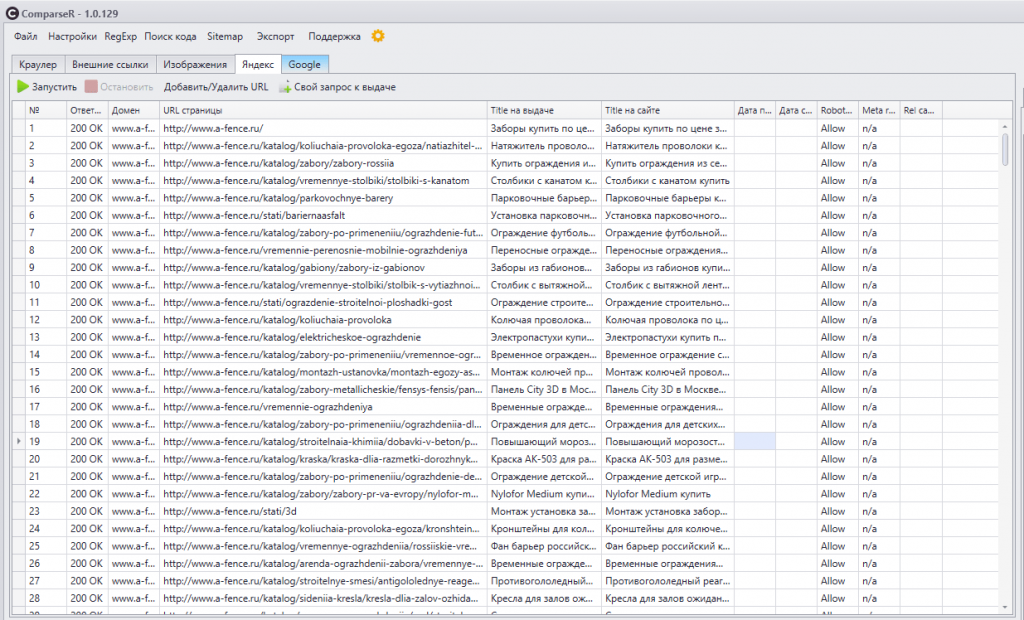

ComparseR 1.0.129

ComparseR 1.0.129 – досить хороший парсер, відмінно справляється з парсингом сайту. Варто відзначити, що його основне завдання – не просто спарсити сторінки сайту, а перевірити його індексацію в пошукових системах. Інструмент має великий функціонал, не вистачає лише списку посилань на сторінку і зі сторінки. В іншому ж все відмінно.

З додаткових функцій у нього є:

- Перевірка індексації сторінок в Google та Яндекс (показує всі проіндексовані сторінки в ПС, може показати навіть ті сторінки, які були відфільтровані для парсингу). Це дійсно класна функція, за допомогою якої можна дізнатися, які сторінки проіндексовані, а які – ні.

- Перегляд структури сайту.

- Пошук коду або тексту на сторінках.

- Генерація Sitemap.

- Можливість парсити багатосторінкові сайти.

- Парсинг сайтів, які потребують авторизації.

- Перевірка індексації сайту при тому чи іншому заповненні robots.txt.

Загалом, як бачимо, функціонал хороший. Парсер простий і зручний, складнощів у роботі з ним не виникає.

Парсинг сайту зайняв 2:56 – це відмінний результат.

Оцінка: 16,5 балів

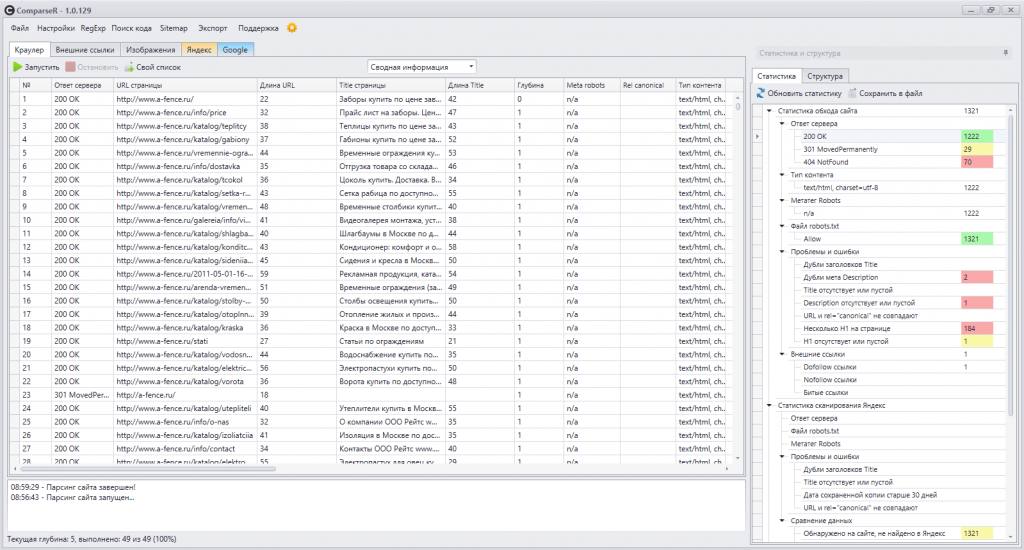

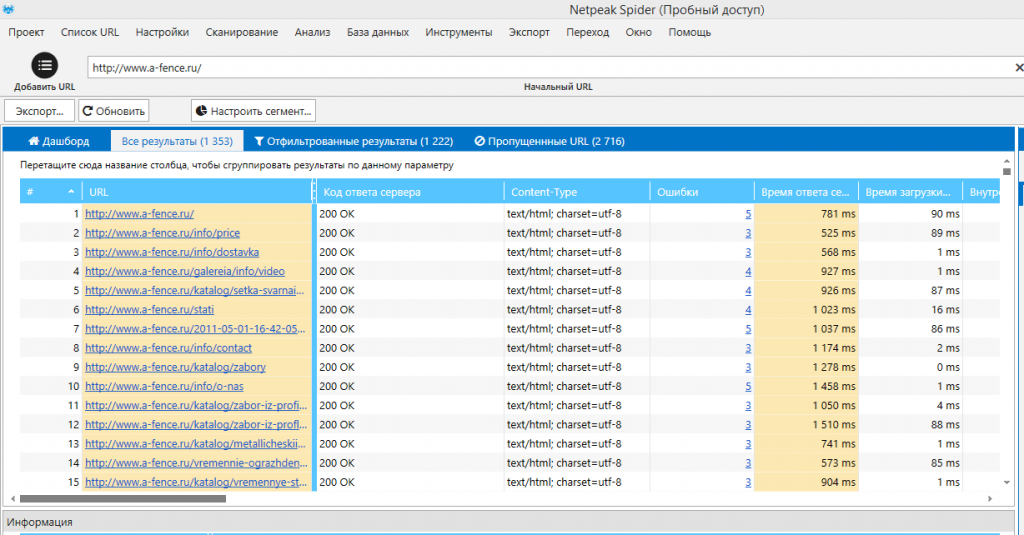

Netpeak Spider 3.0

Netpeak Spider 3.0 – це нова версія парсера, яка вийшла зовсім недавно. Як і Screaming Frog, він добре справляється з парсингом сайту. Основні відмінності від «жаби»: більш зручний і зрозумілий російськомовний інтерфейс і наявність додаткових функцій.

Розробники Netpeak Spider 3.0 пишуть, що він справляється з великими сайтами з малою витратою ресурсів комп’ютера. Така оптимізація дійсно корисна, адже не кожна «машина» зможе впоратися з сайтом-мільйонником. Щоб спарсити такі сайти, часом доводиться користуватися віртуальною машиною з кращими характеристиками, а це додаткові витрати.

У ньому є весь обов’язковий функціонал, звичайно, було б дивно, якщо за таку ціну у нього не було якихось функцій. Є питання до блоку помилок: спірний момент з приводу розподілу помилок і чому не зробили розподіл по всіх помилках певного типу. Наприклад, загальний пункт помилок заголовків H зі списком помилок по цьому пункту і так по всім помилкам.

З особливостей можна виділити:

- Зручне налаштуваня фільтрів.

- Інтерактивний і зручний інтерфейс.

- Можливість вивантажити окремі звіти, які вас цікавлять.

- Можна отримати інформацію за певним URL без зайвих кліків.

- Перегляд структури сайту.

- Можливість задавати призначений для користувача robots.txt для сканування.

- Парсинг сайтів, які потребують авторизації.

- Пошук коду або тексту на сторінках сайту.

- Налаштування швидкості парсингу.

- Можливість зупинити і продовжити парсинг в інший час.

- Перенесення даних по проекту на інший комп’ютер.

Цей парсер впорався зі скануванням нашого сайту всього за 5 хвилин, що теж досить швидко.

Оцінка: 17 балів

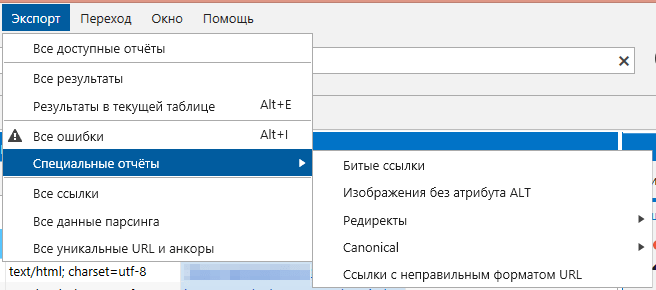

Xenu’s Link Sleuth

Xenu’s Link Sleuth – цей парсер призначений для пошуку битих посилань, тому його функціонал сильно відрізняється від функціоналу програм, описаних вище. Інструмент безкоштовний, що не може не тішити.

Зі своїм основним завданням він справляється відмінно, хоча має мінус – не вказує посилання зі сторінки і на сторінку. Для детального аналізу він не підійде. Якщо вам потрібно дізнатися, чи є биті посилання на сайті, і який рівень вкладеності сторінок, можете сміливо використовувати Xenu’s Link Sleuth.

Якщо потрібна додаткова інформація про сайт, краще виберіть інший парсер.

Парсинг сайту зайняв 17:59 хвилин – це не так швидко, як хотілося, але прийнятно.

Оцінка: 8 балів

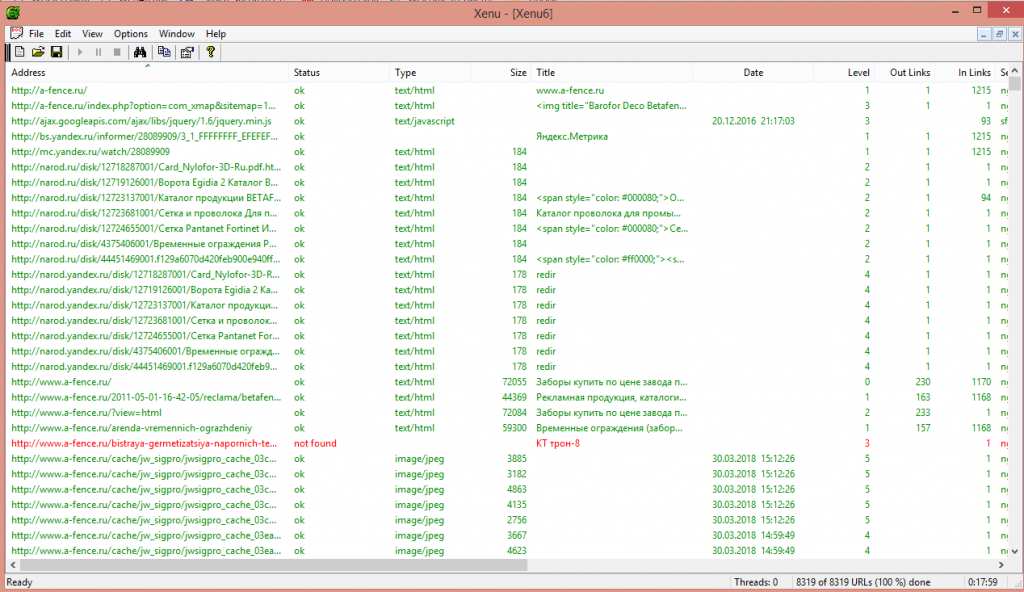

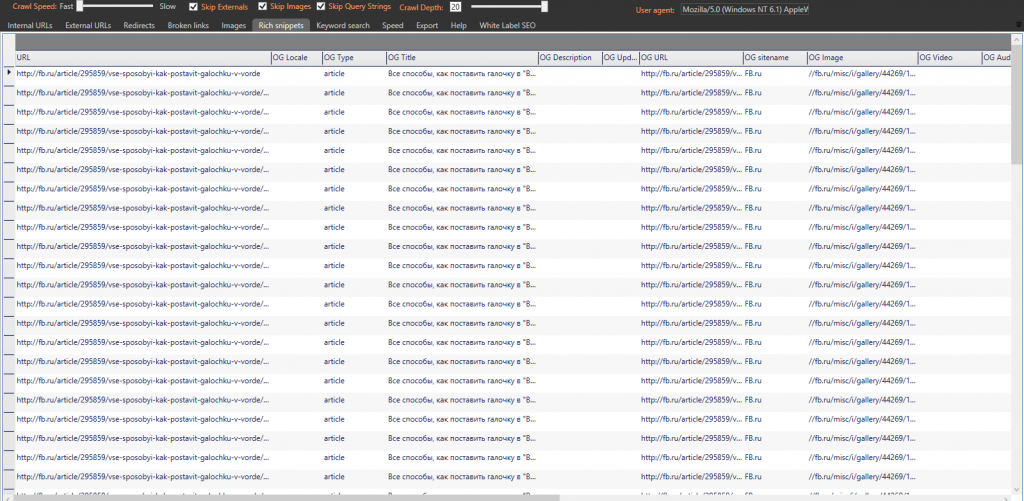

WildShark SEO Spider

WildShark SEO Spider – це безкоштовний західний парсер, він дуже простий і тим самим зручний. Має більше функцій, ніж Xenu’s Link Sleuth, але їх все ж недостатньо. Парсер підійде для швидкої оцінки технічного стану сайту, але для більш детального аналізу доведеться шукати іншу програму.

З особливостей можна виділити підказки на правій стороні екрану, в яких вказується помилка і загальна інформація про неї. Також інструмент може парсити OG мікророзмітки – це досить рідкісна функція, яку не часто зустрінеш.

Спарс сайт за 9 хвилин. Як для безкоштовного парсеру – це відмінний результат.

Оцінка: 9,5 балів

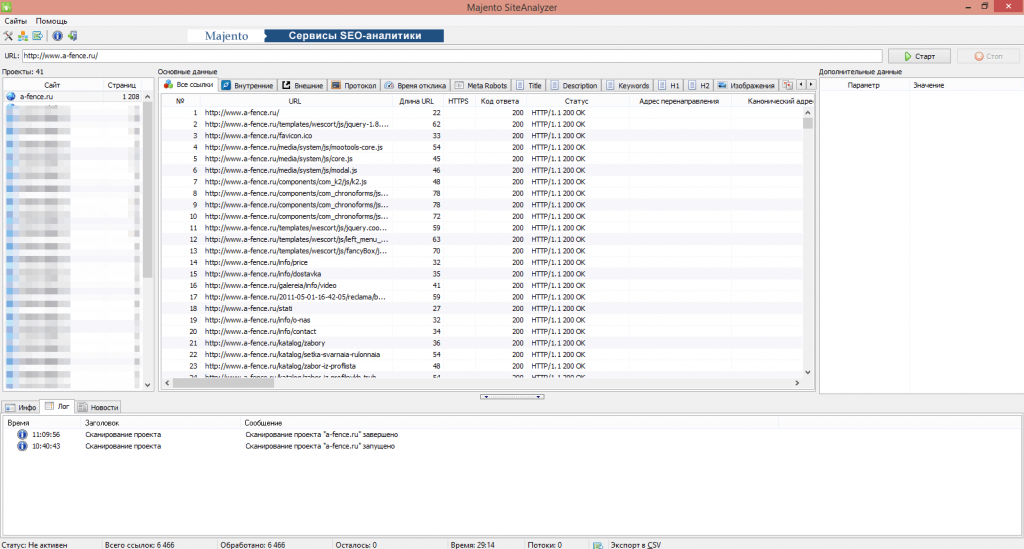

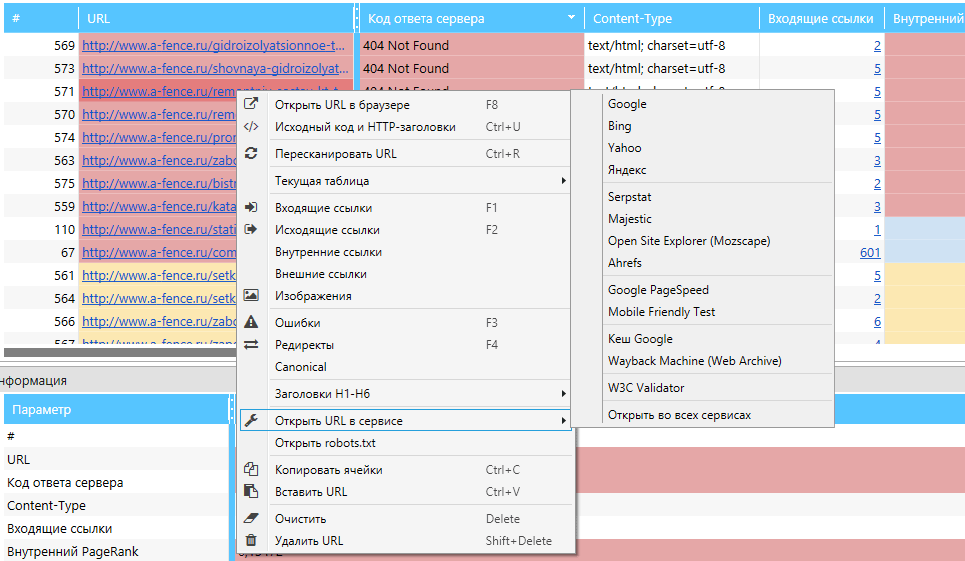

Majento SiteAnalayzer 1.4.4.91

Majento SiteAnalayzer 1.4.4.91 – досить хороший і зручний безкоштовний парсер вітчизняного виробництва. За функціоналом помітно відрізняється від західних аналогів (в кращу сторону). У програми є 2 мінуса:

- повільна швидкість роботи;

- не вказує кількість заголовків H.

На мою думку, це прекрасна заміна платних аналогів. З його допомогою можна детально перевірити сайт і отримати практично всю потрібну інформацію.

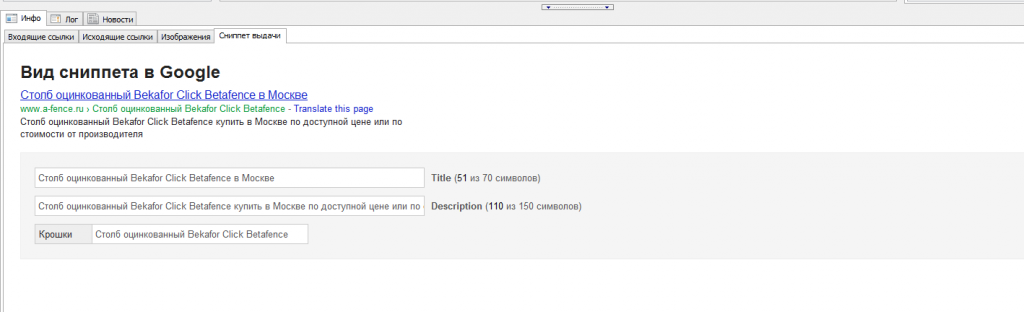

Він не може похвалитися великою кількістю додаткових функцій, але вони все ж таки є. За допомогою Majento SiteAnalayzer 1.4.4.91 можна:

- Згенерувати Sitemap.

- Подивитися структуру сайту.

- Подивитися, як виглядає сниппет в Google.

Як я писав вище, у нього «кульгає» швидкість роботи. Інструмент спарсив наш сайт за 29:14 хвилин – це довго, але функціонал покриває цей недолік. Не забуваємо, що програма безкоштовна.

Оцінка: 16,5 балів

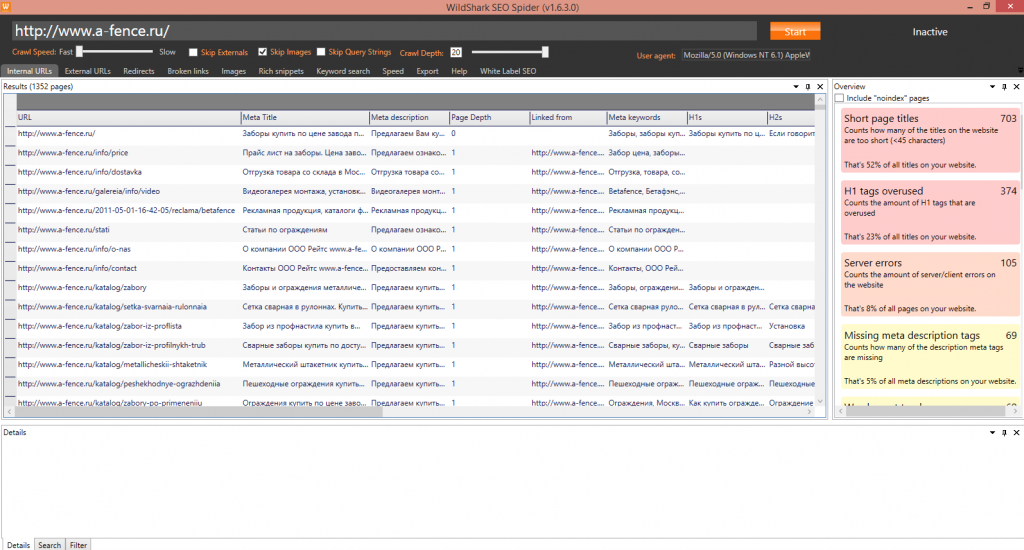

Висновки

У таблиці нижче я порівняв кожен з парсерів за його функціоналом, часом, затраченим на парсинг сайту, зручністю та ціною. З приводу функціоналу варто уточнити: я порівнював лише за тими функціями, про які писав на самому початку, тобто з обов’язковими.

| Парсер | Screaming Frog SEO Spider 9.2 | ComparseR 1.0.129 | Netpeak Spider 3.0 | Xenu’s Link Sleuth | WildShark SEO Spider | Majento SiteAnalayzer 1.4.4.91 |

| Функціонал | ||||||

| Пошук битих посилань | √ | √ | √ | √ | √ | √ |

| Вказівка вхідних і вихідних посилань сторінки | √ | x | √ | √ | x | √ |

| Вказівка типу і ланцюжка редиректу | √ | √ (початковий і кінцевий URL) | √ | x | √ (початковий і кінцевий URL | √ (початковий і кінцевий URL) |

| Можливість фільтрувати сторінки | √ | √ | √ | √ | √ | √ |

| Парсинг окремих URL | √ | √ | √ | √ | x | x |

| Вказівка дублів Title, Description і заголовків H | √ | √ | √ | x | √(тільки заголовків H) | √ |

| Вказівка рівня вкладеності | √ | √ | √ | √ | √ | √ |

| Вказівка заголовків H і їх кількості | √ | √ | √ | x | √ (тільки текст) | √ |

| Код відповіді сервера | √ | √ | √ | √ | √ | √ |

| Можливість зміни User Agent | √ | √ | √ | x | √ | √ |

| Title і його довжина | √ | √ | √ | √ (тільки текст) | √ (тільки текст) | √ |

| Description і його довжина | √ | √ | √ | √ (тільки текст) | √ (тільки текст) | √ |

| Keywords і його довжина | √ | √ | √ | x | √ (тільки текст) | √ |

| Canonical | √ | √ | √ | x | √ | √ |

| Meta robots | √ | √ | √ | x | x | √ |

| Alt, його довжина і розмір | √ | √ | √ | x | √ (довжину не вказує) | √ |

| Тип контенту | √ | √ | √ | √ | x | √ |

| Оцінка функціоналу | 17 | 16,5 | 17 | 8 | 9,5 | 16,5 |

| Час сканування | ||||||

| 03:00 | 02:56 | 05:00 | 17:59 | 09:00 | 29:14 | |

| Зручність | ||||||

| 3 | 4 | 5 | 4 | 4 | 4 | |

| Вартість * | ||||||

| 149£/рік | 2000 руб | 14$/в місяць | Безкоштовно | Безкоштовно | Безкоштовно | |

* Вказана вартість підписки на момент написання статті без урахування знижок і акцій.

Кожен з представлених парсерів по-своєму хороший. Деякі не сильно відрізняються один від одного, інші більш вузьконаправлені. Однозначно сказати, який з парсеров найкращий – не можна, але розподілити їх можна.

Серед платних інструментів конкурують Netpeak Spider і Screaming Frog SEO Spider. У цих парсеров великий функціонал, який в повній мірі покриває всі потреби, але варто відзначити, що їх ціна далеко не низька.

ComparseR має не менший функціонал і цілком відмінно справляється з технічним аналізом сайту. З його допомогою можна дізнатися, які сторінки в індексі, що теж важливо. Ціна парсеру – всього 2 тис. рублів.

Серед безкоштовних парсерів однозначно лідирує Majento SiteAnalayzer. Його функціоналу досить для аналізу сайту, єдиний і головний мінус – тривалий час парсингу.

Еще по теме:

- Відстеження відправки форм на сайті за допомогою GTM

- Групування запитів за методом подібності ТОПів: опис, кластеризатори

- Як провести аудит посилальної маси сайту за допомогою Ahrefs

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.