- (Обновлено:

Євген Аралов розповів, як поліпшити видимість сайту у видачі за рахунок правильного складання семантичного ядра, про ефективні способи збору і фільтрації ключових запитів і складнощі, які можуть виникнути в процесі угруповання семантики.

Нижче дивіться відеозапис вебінару, під відео можна завантажити презентацію і прочитати текстову версію вебінару.

Чекаємо вас на наступних вебінарах!

Відеозапис вебінару (29.04.2015)

Презентація Як створити ефективне семантичне ядро

Текстовий зміст вебінару

Почати я хочу з Миінусинська, який Яндекс повинен запустити 14 травня – новий алгоритм, який буде банити за використання SEO-посилань. Це говорить про те, що посилання йдуть, і тепер нам треба більш уважно займатися внутрішньою оптимізацією, а вона починається з роботи над семантичним ядром.

Можна сказати, що семантика – наше все.

Від повноти семантики залежить ефективність всього сайту в майбутньому (зокрема продажі: якщо на початковому етапі ми правильно зберемо семантику, то будемо отримувати трафік: якщо помилимося, не зрозуміємо попит – будемо втрачати клієнтів і продажі).

Алгоритм підготовки СЯ:

- Формування маркерів

- Збір запитів (хмара ключових запитів)

- Чистка і фільтрація

- Групування

Формування маркерів

Маркер – запит, який однозначно відповідає сторінці. Тобто якщо у нас є категорія GPS-навігаторів, то маркером для неї буде запит «gps-навігатор». Грубо кажучи, це слово, яке характеризує сторінку.

На початковому етапі важливо правильно підібрати ці маркери, так буде простіше збирати повне семантичне ядро.

Де їх отримувати?

– Вивантаження Яндекс.Метрики

– Парсинг свого сайту або конкурента

– Самостійно – виходячи з логіки («мозковий штурм»)

Вивантаження з Яндекс. Метрики – це найпростіший спосіб. Якщо ваш сайт вже працює, ви можете подивитися попит конкретно на ваш сайт. Це зручно – ви відразу знаєте посадкову сторінку, орієнтовну категорію.

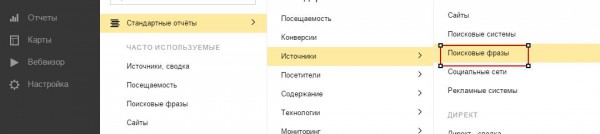

Я рекомендую використовувати нову метрику 2.0 – вона зручна тим, що там вже є готові звіти за пошуковими фразами + URL. У старій Метриці треба скористатися конструктором, щоб отримати звіт.

Стандартні звіти – Джерела – Пошукові фрази:

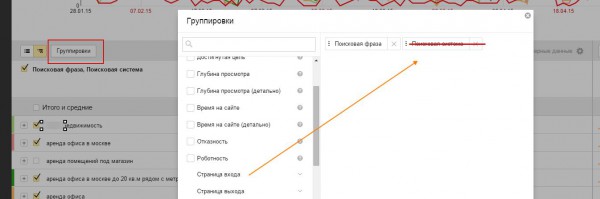

Групування> Прибираємо «Пошукові системи»> Вставляємо «Сторінки входу»:

Групування> Прибираємо «Пошукові системи»> Вставляємо «Сторінки входу»:

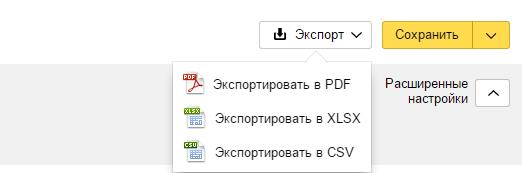

Після цього нам все треба вивантажити в Excel, справа вгорі є кнопка «Експорт»:

Після цього нам все треба вивантажити в Excel, справа вгорі є кнопка «Експорт»:

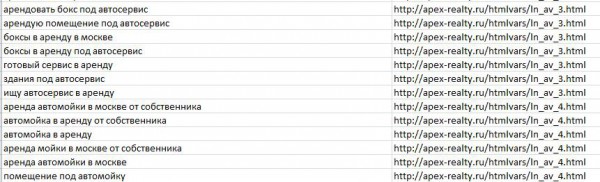

Вони вже є маркерами, під них ми будемо підбирати уточнюючі слова.

Парсинг. Ми можемо парсити title по розділах свого сайту або сайту конкурента.

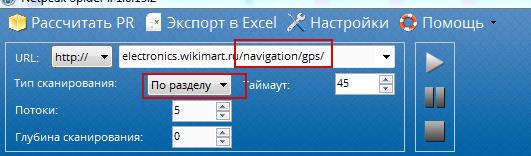

Чим парсити – програма Netpeak Spider, SEO Screaming Frog (платна).

Беремо розділ, вставляємо, вибираємо «Згідно з розділом» і натискаємо Play:

У підсумку ми отримуємо title усіх цих розділів, після того, як ми отримали вивантаження, завантажуємо всі ці дані в Excel.

Тепер ці title нам треба розбити на n-грами.

N-грами – ряд слів. Послідовність з двох-трьох елементів, часто – біграм (з двох слів); послідовність з трьох елементів називається триграма і т.д.

Як це зробити? Качаємо програму N-Gram Extraction Tools. У папці створюємо файл, наприклад, in.txt, в нього завантажуємо наші отримані тайтли і в командному рядку задаємо: text2ngram – n3 in.txt> out.txt,

де n3 – тип n-грами (в даному прикладі це триграмма), in.txt – вхідний файл з фразами, out.txt – вихідний файл з отриманими n-грамами і частотним словником.

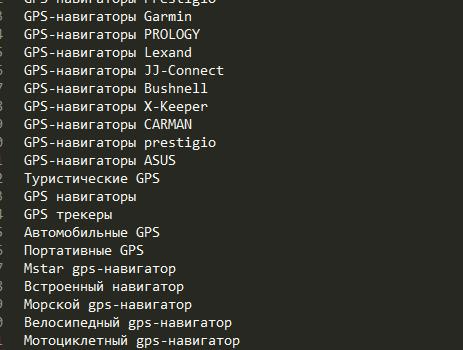

Після чищення від «сміття» ми отримуємо такий файл:

Звичайно, довелося трохи почистити «сміття» вручну, але це не так довго і складно.

Збір запитів

Парсимо за маркерними словами з різних джерел

Інструменти:

Wordstat

+ Повнота, актуальність і доступність

– Частина запитів накручена

Пошукові підказки

+ Повнота і висока актуальність

– Під час парсингу генеруються «сміттєві» (фантомні) підказки: [gps навігатор мотоциклетний акумулятор]. Коли ми набираємо «gps навігатор мотоциклетний», нам підставляється слово «акумулятор». Це не запит, і це треба враховувати під час чищення.

Сервіси SemRush, SpyWords, Prodvigator (можуть використовуватися для маркерних запитів)

+ Швидкість

– Низька повнота, всі вони платні

Якщо ви готуєте якісну, повну семантику, не варто сліпо спиратися на такі сервіси.

Різні готові бази

+ Швидкість (нічого не парсимо, просто робимо вибірку)

– Багато «сміття» і неактуальність (не зрозуміло, ким і як зібрана ця база, прямого відношення до пошуку вона не має)

Користуватися такими базами варто тільки в окремих випадках, спиратися на них не слід.

У підсумку ми отримуємо таку схему збору запитів:

Маркери – Wordstat (ліва колонка) – Підказки *

* Враховуйте геозалежні – у Саратові у вас будуть зовсім інші підказки, ніж в Москві

Все це може робити Keycollector або Slovoeb.

Чистка та фільтрація

1. Частка стоп-слів. Треба їх шукати самому або у пабліку. Ті, хто займається складанням семантичного ядра, повинні мати свій список стоп-слів. Це можуть бути:

- Для комерційних сайтів: нецільові топоніми (купити навігатор у Саратові), явно некомерційної суті (онлайн, дивитися, завантажити, безкоштовно), бренди конкурентів і т.д.

- Для кожної тематики окремо: «ремонт», якщо послуга ремонту не надається, ios – для магазину навігаторів і т.д.

- Загальні для всіх сайтів: порно, назви соц.мереж

За стоп-словами чистить Slovoeb і Key Collector.

2. Прибираємо навігаційні запити ([gps навігатор в ельдорадо], [ресторан біля річки]).

Відсівати руками їх досить складно. Є 2 методи фільтрації:

А. Аналіз видачі за запитами

Гіпотеза: якщо сайт займає кілька верхніх позицій, то запит навігаційний.

Метод: зібрати ТОП10 url видачі Яндекс по запиту, перевірити чи є кілька однакових доменів серед отриманих url, якщо так – запит вважаємо навігаційним.

Реалізувати можна через Key Collector – Докладніше про методику на блозі Ігоря Бакалова bakalov.info.

Б. Колдунщик Google

Гіпотеза: якщо за запитом в Google з’являється карта – запит навігаційний.

Метод: аналізуємо видачу за запитами (потрібно писати скрипт або руками).

Ще один спосіб – парсити xml-видачу – якщо у вас є можливість написати скрипт, його можна використовувати. Яндекс підсвічує вітальні сайти у видачі, якщо сайт вітальний – запит навігаційний.

Вітальний сайт – сайт, найбільш релевантний за запитом. Наприклад, за запитом Samsung вітальним буде сайт компанії Samsung. Яндекс визначає такі сайти і виділяє їх, у XML-видачі ми можемо це побачити.

3. Ділимо на комерційні та інформаційні – найскладніша частина.

ВАЖЛИВО! Не можна просувати на одній сторінці комерційний та інформаційний запит.

Складність в тому, що не завжди очевидно, який запит для Яндексу комерційний, який – інформаційний.

Приклад:

[Розчин для кладки цегли] – інформаційний запит

[Суміш для кладки цегли] – комерційний запит

На око визначити це не вийде.

Методи фільтрації

Аналіз вмісту сторінок конкурентів з ТОП за запитом

Гіпотеза:

А) Чим більше в ТОПі комерційних сайтів, тим більше запит є комерційним. Тобто якщо у нас 3 сайти комерційних і 7 інформаційних, то запит, швидше за все, інформаційний. І навпаки.

Б) Комерційний сайт продає товари або послуги => для комерційного сайту характерно: наявність кошика, інформації про доставку та оплату, кнопки «Купити», реквізитів і т.д.

В) Інформаційний сайт нічого не продає, може містити рекламні блоки.

Висновок: чим більше документів ТОПу за запитом q містять суті, характеризують комерційний сайт, тим ймовірніше, що запит q – комерційний.

Метод: зібрати ТОП10 url видачі Яндексу за потрібним запитом, спарсити контент кожного документу, проаналізувати отриманий вміст на наявність комерційних та інформаційних сутностей. Якщо документ комерційний – присвоюємо 1, якщо інформаційний – присвоюємо 0. Підсумовуємо значення і ділимо на 10. Отримуємо ранк комерційності для запиту.

Інструменти: ZennoPoster або інший парсер, Excel

Методика Ігоря Бакалова, докладний опис і приклад реалізації на сайті bakalov.info

Як конкретно Яндекс визначає, комерційний запит чи ні, не зрозуміло. Ця методика орієнтовно допомагає визначити.

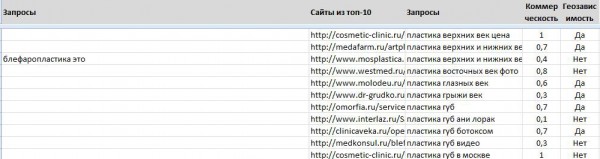

Результат:

1 – комерційний запит, 0,3 – це вже некомерційний запит, 0,7 – більше комерційний

Групування

Після того, як ми зібрали маркери, підібрали запити, розподілили їх на комерційні та інформаційні, прибрали навігаційні запити, нам треба їх погрупувавати.

Як ми групуємо?

- За маркерами: категорія, категорія + бренд, категорія + уточнюючі слова

- За типом: комерційний (на комерційні сторінки) або інформаційний (на інформаційні)

- За відповідностю: специфічні сутності контенту (відгуки, онлайн, відео, фото) – на окремі сторінки (або на картках товару)

- За сторінками: головна або внутрішня (якщо за запитом в ТОПі головна сторінка, то внутрішню ви туди не просунете, запит треба садити на головну)

Способи групування:

Ручний (за невеликих обсягів може використовуватися, але починаючи з 1000 запитів це довго і, швидше за все, неякісно).

За маркерами. Ми беремо, наприклад, маркер «купити» і назву категорії і групуємо всі сторінки за цими маркерами. Або назва категорії + бренд.

Це просто автоматизувати – в Key Collector можна фільтрувати і групувати запити за певними маркерами, що вже збільшує швидкість роботи.

Можна написати свої скрипти, але є деякі складності:

gps навігатор navitel

Gps навігатори навітел

gps навігатор navitel A720

gps навігатор navitel A–720

Жпс навігатор navitel

Під час маркерного групування потрібно враховувати різні словоформи та інші випадки. Якщо групувати за маркером “навігатор”, то ключові слова “навігатори” не згрупуються. Через такі неточності можуть бути прогалини в повноті та правильності групування.

Порівняння SERP (видачі). Беремо запит 1, вбиваємо його в Яндекс, беремо запит 2, також вбиваємо його в Яндекс і дивимося, які перетину і наскільки їх багато за цими двома запитами. Якщо збігів багато: перетинаються сторінки, у конкурентів на одних і тих же сторінках сидять одні й ті ж запити – ми відразу можемо групувати ці запити разом.

Це кращий варіант, ми відразу прибираємо питання, комерційний запит чи інформаційний, оскільки ТОПи нам брехати не будуть, навряд чи на одній сторінці буде як комерційний, так і інформаційний запит. Швидше за все, буде відразу 2 комерційних або 2 інформаційних. Але є серйозна проблема – автоматизувати цей процес досить складно. Якщо у нас велика кількість запитів, кожен запит повинен попарно бути почеканий і попарно повинні бути перевірені серпи.

Але однозначно хочу сказати: якщо ви перевіряєте вручну, порівнюйте SERPи. Припустимо, ви згрупували запити за маркерами – дивіться, чи перетинаються ці запити за топами.

Це важливо, оскільки якщо ви не будете звертати уваги на ТОП, можуть виникнути труднощі:

1. Який тип сторінки: головна або внутрішня. У ТОПі можуть бути одні головні, а ви намагаєтеся посадити запит на внутрішню сторінку.

2. За типом: комерційний чи інформаційний – у ТОПі можуть бути одні інформаційні запити, хоча це питання ми вирішуємо ще на етапі фільтрації та сортування.

3. Маркери: садять запити типу [категорія + уточнююче слово1] і [категорія + уточнююче слово2] на одну сторінку.

Приклад: [облицювальна цегла фасадна], [облицювальна цегла для дому]

Просунути їх можна, але так робити не слід – це різні сторінки для просування.

4. Ситуація «Третій зайвий».

У нас є запити:

[Запит А]

[Запит Б]

[Запит В]

За запитом А і Б є перетин у ТОПі, за запитом Б і В – також є перетин, а запити А і В не перетинаються. Тобто запит А і В просунути на одній сторінці не можна.

5. Синоніми: у Яндексу своя база синонімів. Згідно з нашою логікою, [прибирання в москві] та [кліннінг в москві] – синоніми, а для Яндексу вони синонімами не є. Тому посадити їх на одну сторінку і просунути буде складно – під час розробки структури враховуйте це.

Не бійтеся створювати сторінки, звичайно, не варто створювати окремі сторінки під запити «купити gps навігатор» і «купити gps навігатор дешево», це буде сприйматися як спам.

Детальніше про групування запитів у нас на блозі.

Питання слухачів:

– Скільки інформаційних запитів можна посадити на сторінку?

Як завгодно багато. Можете зайти в Яндекс.Метрику, зробити фільтрацію за одним урлом і подивитися, скільки запитів веде на один урл. Немає жодних обмежень, головне, щоб вони були посаджені грамотно, відповідали інтенту сторінки і були корисні для користувачів.

– Де можна подивитися синоніми?

Синоніми треба парсити, є модуль «Синоніми за запитами» в seolib.ru.

– Я не розумію, як все ж формувати маркери? Невже не можна просто пробити мозковим штурмом все, що стосується твоєї тематики?

Можна, але простіше і повніше вийде, якщо ви цей процес автоматизуєте. Але тут є невеликий нюанс: не варто підбирати запит і маркер тих категорій, які ви не продаєте. Це логічно, але це не всі розуміють.

– Перерахуйте сервіси по групуванню семантики, якими користуєтеся.

В основному це Key Collector і внутрішні скрипти. Можу порекомендувати Rush Analytics, https://py7.ru/tools/text/.

– Запит, в якому присутнє уточнення місця, наприклад, “ресторан в Москві” геозалежний чи ні?

Ні, не геозалежний, тому що «в Москві» уточнює, швидше за все, з будь-якого регіону буде однакова видача.

– Чи може розділ в одній статті бути однаковим з тайтлом іншої статті? Наприклад, в “Кориці” написати загальну інформацію і коротко про застосування в кулінарії і зробити ще одну статтю виключно про застосування в кулінарії?

Питання таке, риторичне, я б радив розглядати його з боку корисності для користувача: якщо обидві ці статті корисні і кожна з них містить якийсь унікальний інтент, то можна писати. Якщо одне і те саме написано різними словами, то це буде сприйматися як спам.

– А для збору семантики під буржнет чим користуєтеся?

Дуже добре підходить Semrush.

– Якщо клієнт хоче просувати запит, як у прикладі про цеглу для фасаду, але сторінку створювати не хоче. Що робити?

Треба переконати його у цьому, показати йому ТОП, пояснити, що це безглуздо. Це як приїхав чоловік на сервіс. Йому кажеш: «Треба тобі рульову тягу робити». А він каже: «Ні, я не хочу, я ось так буду їздити, але ви мені зробіть, щоб я міг 160 йти по трасі і з машиною нічого не сталося. І ще відповідальність несіть за це. Давайте з вами договір укладемо, що я не розіб’юся ». Дурість.

– Так в Google можна вести на 1 сторінку комерційні та інформаційні запити?

У деяких випадках так, можна вести, там немає такого конкретного поділу, як у Яндексі. Усе одно також аналізуйте ТОП, але це цілком можливо.

– А як з регіональними вчинити? Створювати 100500 сторінок з одним текстом, але різними регіонами?

Регіональність – це окрема історія. Якщо коротко: сайт повинен бути в Яндекс, він вам дасть змогу привласнити 7 регіонів, якщо у вас є там представництва. Така реалізація «створити 100500 сторінок» можлива, але треба не просто міняти місто, а робити реально корисний контент для кожного регіону.

– А якщо більше 7 регіонів?

Це складніше. Можна підключати піддомени і рухатися за ними, кожному привласнюючи свій регіон. Якщо у вас немає представництв, то це складно, у Яндексі з цим досить проблематично. Регіон «Росія» – це ні про що в Яндексі. Робіть піддомени, регіональний контент, можна навіть, щоб ціни відрізнялися. Якщо це буде явно спам, Яша може і покарати. Простого виходу немає, у вас повинні бути представництва або хоча б вивезення, ви можете додати у Яндекс.Довідник усі ці адреси, це вже поліпшить ранжування по регіонах.

– Якщо тематика вузьконаправлена, то і просуватися складніше? Або ж навпаки?

Треба дивитися ТОП, якщо в ТОПі одні прайс-агрегатори типу Вікімарт, Яндекс.Маркет, price.ru і т.д. вузькотематичні сайти, туди залізти буде нереально, якщо навпаки – там одні вузькотематичні сайти, що продають лише акустику, наприклад, – швидше за все, туди буде важко високопрофільному сайту залізти.

– Для Гуглу тепер посилання теж не потрібно купувати?

Потрібно, але не купувати. Потрібно їх отримувати, сьогодні це досить складно, ми займаємося так званим крауд-маркетингом – є фахівець, який не сидить на біржах, не купує посилання, а нарощує природну кількість посилань.

Цей спосіб дуже ефективний, але вимагає багато часу. Про крауд-маркетинг чекайте окрему статтю, буде на нашому блозі незабаром.

Еще по теме:

- Юзабіліті на практиці – покращуємо конверсію, позиції та трафік (відео з вебінару)

- Правила формування title та description (відео і текст вебінару)

- Запис і текст вебінару: Як проаналізувати сайти конкурентів

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.